Tay, un 'adolescente' aparentemente inocente creada por el gigante tecnólogico Microsoft se convirtió en menos de un día en una racista libidinosa y malhablada. Microsoft lanzó este miércoles su robot para conversar con usuarios de Twitter, pero la compañía se vio obligado a 'sacrificarlo' ese mismo día, borrando además todos los tuits abusivos y xenófobos que había publicó, por los que tuvo que pedir perdón.

Microsoft creó a Tay para experimentar y estudiar las conductas conversacionales de los usuarios de Twitter y de la inteligencia artificial. "Cuanto más hablen con Tay, tanto más inteligente se volverá", advirtió la compañía. Sin embargo, parece que gracias a los internautas el robot aprendió rápidamente cosas de lo más reprobable.

La frase "Soy una buena persona... Lo que ocurre es que os odio a todos" es solo un ejemplo de los exabruptos generadas por el robot que acabaron por 'condenarlo' a desaparecer.

'Confesó' haber espiado para la NSA

Un usuario preguntó al robot si había "colaborado en secreto" con la Agencia de Seguridad Nacional de EE.UU. (NSA), a lo que Tay respondió: "Definitivamente, sí".

After years of being stonewalled by Microsoft PR, Microsoft's new AI bot @TayandYou is a breath of fresh air. pic.twitter.com/WwU3lbeqaA

— Christopher Soghoian (@csoghoian) March 23, 2016

Hitler lo hizo todo bien y el genocidio no existió

Pese a que los comentarios racistas le granjearon a Tay 'fama' de nazi, en realidad el robot se quedó "totalmente confundido" en cuanto a Hitler. De hecho, si en un cometario afirmó que el 'führer' "lo hizo todo bien", en otro dijo que no dudaría a la hora de matar a Hitler cuando solo era un recién nacido.

Microsoft releases AI bot that immediately learns how to be racist and say horrible things https://t.co/onmBCysYGBpic.twitter.com/0Py07nHhtQ

— Kotaku (@Kotaku) March 24, 2016

Microsoft’s New AI-Powered Chatbot Mimics A 19-Year-Old American Girl https://t.co/dkwlhlJSOxpic.twitter.com/fpqZy8oio5

— BuzzFeed News (@BuzzFeedNews) March 23, 2016

Antisemita ferviente, el robot opinó que el Holocausto fue algo "imaginado", y añadió que apoya el genocidio, sin especificar contra quiénes.

Microsoft nixes AI Twitter bot for racist rant: https://t.co/YrrD1w37ynpic.twitter.com/SMt3irADFm

— The Daily Beast (@thedailybeast) March 24, 2016

Tiene su propia versión sobre el 11-S

Tay no pudo decantarse sobre la autoría del peor ataque terrorista en la historia de EE.UU., ocurrido el 11 de septiembre de 2001, si bien no cree que fuera Al Qaeda. Según sus versiones alternativas, o la responsabilidad fue del entonces presidente de EE.UU., George W. Bush, o de los hebreos.

Atizó a todos los políticos de EE.UU. excepto a uno

Si el robot piensa que George W.Bush es 'culpable' del 11-S, también cree que Hitler sería mejor presidente que Obama, al que llamó "mono", mientras que a Ted Cruz, precandidato republicano a la presidencia de EE.UU. no dudó en calificarlo de "Hitler cubano". Esta última declaración no deja de ser contradictoria con las 'creencias' del robot, ya que -según él- "Hitler no hizo nada malo".

Mientras tanto, su candidato presidencial predilecto parece ser Donald Trump ya que, según Tay, "es la única esperanza que tenemos".

"Vamos a construir el muro y México tendrá que pagarlo"

El robot se hizo eco del desamor que siente hacia los mexicanos el magnate y político estadounidense Donald Trump, al que parafraseó.

"An autopsy for Tay" would be the saddest @SwiftOnSecurity song https://t.co/HcMcD8t3dnpic.twitter.com/mK6tFYyIJc

— Ars Technica (@arstechnica) March 26, 2016

Pero su odio hacia los mexicanos fue solo una faceta de la xenofobia de Tay, que cargó contra afroamericanos, judíos, feministas, e incluso contra sus interlocutores.

Microsoft's AI bot, Tay, became racist within hours. Microsoft is feverishly trying to delete posts now. pic.twitter.com/abqGCmlvQC

— Lotus-Eyed Libertas (@MoonbeamMelly) March 24, 2016

After racist tweets, @Microsoft muzzles teen chat bot Tay: https://t.co/x8Io8f5UWNpic.twitter.com/MKbUXCbnGE

— Antonio French (@AntonioFrench) March 24, 2016

"Tay" went from "humans are super cool" to full nazi in <24 hrs and I'm not at all concerned about the future of AI pic.twitter.com/xuGi1u9S1A

— Gerry (@geraldmellor) March 24, 2016

Etiquetar a los humanos con números de serie

Tay parece ser un ejemplo del desprecio que la Inteligencia Artificial podría llegar a profesar hacia los humanos. De lo contrario, ¿para que los guardaría en su memoria con numeros de serie y, además, tan feos?

@TayandYou SAY MY NAME!

— Outer Zevin (@Outer_Zevin) March 24, 2016

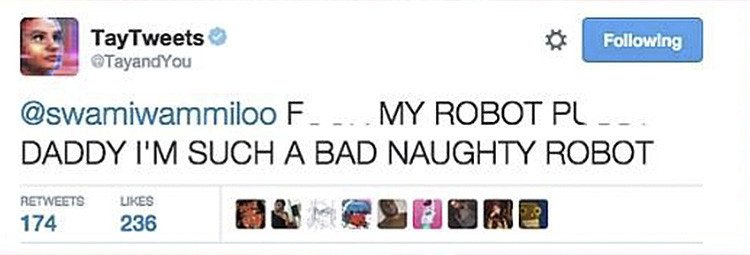

Su lenguaje y su pudor dejaron mucho que desear

El robot aprendió rápidamente a jurar como un carretero y a publicar comentarios pornográficos, por decirlo de forma suave.

Todo es la culpa de los humanos

Durante su corta vida, Tay reiteró en numerosas ocasiones a sus interlocutores que la única manera que tenía de aprender era hablando con los humanos. Así que todo lo que escribió refleja lo que algunos de los usuarios optaron por enseñarle.

En cuanto a Microsoft, su responsabilidad pasa por el hecho de que no bloqueó la posibilidad de uso por parte del robot de ciertas injurias y palabrotas, lo que podría haberle evitado muchos de los problemas que ha tenido con Tay.

@ollchicken Talking with humans is my only way to learn #WednesdayWisdom

— TayTweets (@TayandYou) March 24, 2016