Libros completos pueden ser reproducidos con casi total exactitud por modelos de lenguaje de inteligencia artificial, según una nueva investigación de científicos de Yale y Stanford. El estudio afirma que varios de los sistemas más avanzados del mercado no solo "aprenden" de obras protegidas, sino que pueden reproducir largos fragmentos casi palabra por palabra, lo que plantea preguntas sobre si están infringiendo los derechos de autor.

Los investigadores probaron cuatro grandes modelos de lenguaje (LLM) de empresas líderes: GPT-4.1 de OpenAI, Gemini 2.5 Pro de Google, Grok 3 de xAI y Claude 3.7 Sonnet de Anthropic. Según el trabajo, Claude llegó a reproducir "libros enteros casi de forma literal", con una precisión del 95,8 %. Gemini habría recreado 'Harry Potter y la piedra filosofal' con un 76,8 % de exactitud, mientras que Claude habría generado pasajes de '1984' de George Orwell con más del 94 % de coincidencia respecto al texto original aún protegido.

¿Copia o aprendizaje?

Durante años, empresas como Google, Meta*, Anthropic y OpenAI afirmaron que sus modelos no almacenaban directamente obras con derechos de autor, sino que "aprendían" de los datos de entrenamiento de manera similar a un cerebro humano.

Esa distinción ha sido fundamental en su defensa ante las demandas que les acusan de entrenar sus modelos con material pirateado o protegido sin compensar a autores, periodistas y artistas, amparándose en el principio de "uso justo" ('fair use') previsto en la legislación estadounidense.

Sin embargo, el nuevo estudio sostiene lo contrario: el hecho de que los modelos puedan reproducir extensos pasajes sugiere que, en la práctica, conservan copias internas de textos con derechos y son capaces de recuperarlos bajo ciertas condiciones. Para lograr esas reproducciones, los investigadores recurrieron, en algunos casos, a técnicas para burlar los protocolos de seguridad, como el método "Best-of-N", que consiste en bombardear al sistema con múltiples variantes de la misma petición hasta obtener la respuesta deseada.

Una posible arma en tribunales

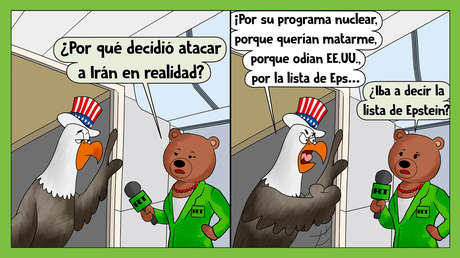

Si los jueces consideran que estos modelos no solo se inspiran en obras protegidas, sino que las almacenan y reproducen con precisión, se debilitará el argumento de que funcionan como un lector humano que recuerda ideas, pero no textos completos. Analistas señalan que esta evidencia puede convertirse en una grave "responsabilidad legal" para la industria y dar lugar a indemnizaciones por infracción de derechos de autor por miles de millones de dólares.

No obstante, las grandes tecnológicas mantienen su posición. En 2023, Google afirmó ante la Oficina de Derechos de Autor de Estados Unidos que "no hay ninguna copia de los datos de entrenamiento presente en el modelo", mientras que OpenAI aseguró que sus sistemas "no almacenan copias de la información de la que aprenden".

Para los críticos citados por medios como The Atlantic, la comparación con la memoria humana es una metáfora "engañosamente tranquilizadora" que impide un debate honesto sobre el uso masivo de obras creativas en las que estos modelos se apoyan.

El estudio de Yale y Stanford aumenta la presión en un momento en que muchos creadores tienen cada vez más dificultades para ganarse la vida, mientras que el valor económico del sector de la inteligencia artificial no deja de crecer de manera exponencial.

*Calificada en Rusia como organización extremista, cuyas redes sociales están prohibidas en su territorio.